Data Management : définition, enjeux et composantes

Qu'est-ce que le data management ?

Le data management, ou gestion des données, désigne l'ensemble des pratiques, processus et technologies qui permettent de gérer vos données sur l'intégralité de leur cycle de vie. De la création à l'archivage, en passant par le stockage, l'utilisation et éventuellement la suppression.

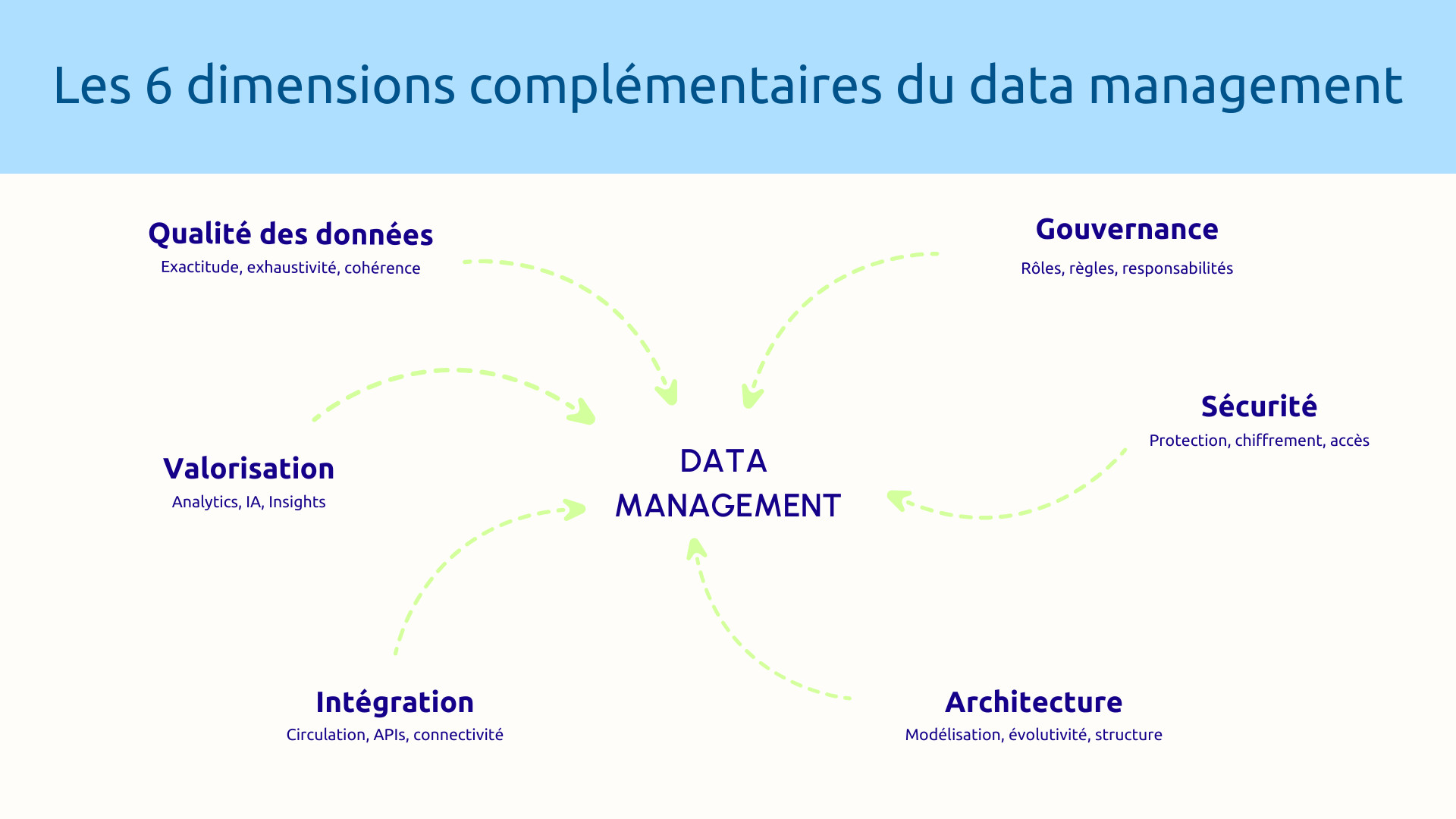

Contrairement à ce qu'on pourrait penser, le data management n'est pas qu'une affaire de bases de données et de stockage. C'est une discipline globale qui englobe plusieurs dimensions complémentaires :

- La qualité des données : garantir que les informations sont exactes, complètes et cohérentes

- La gouvernance : définir qui décide quoi concernant les données et selon quelles règles

- La sécurité : protéger les données contre les accès non autorisés et les fuites

- L'architecture : structurer logiquement le patrimoine data pour l'efficacité et l'évolutivité

- L'intégration : faire circuler les données entre systèmes de manière fluide et contrôlée

- La valorisation : exploiter les données pour créer de la valeur métier via l'analytics et l'IA

Il est important de distinguer le data management de disciplines connexes mais différentes. La data governance est un sous-ensemble du data management qui se concentre spécifiquement sur les règles, rôles et responsabilités. Le data analytics, lui, exploite les données pour en extraire des insights, mais présuppose que le data management est déjà en place.

Pourquoi le data management est critique pour votre organisation ?

Sur le plan de la conformité réglementaire et de la sécurité des données, les enjeux sont considérables. Le RGPD impose des obligations strictes sur la protection des données personnelles, avec des amendes pouvant atteindre 4% du chiffre d'affaires mondial.

Par ailleurs, la qualité des vos décisions et l’efficacité opérationnelle dépendent directement de la qualité des données. Vos décisions stratégiques ne valent que ce que valent les informations qui les fondent. Des données inexactes ou incohérentes conduisent à des décisions erronées, avec des conséquences potentiellement graves : mauvaise allocation des ressources, opportunités manquées, risques non identifiés. Une approche sécurité-by-design s'impose dès la conception.

Enfin, la valorisation des données devient impossible. Vous voulez exploiter l'IA générative ? Elle a besoin de données de qualité, bien structurées et accessibles. Vous voulez développer des analytics avancés ? Même problème. Sans fondations data solides, ces projets ambitieux échouent avant même de commencer.

Les symptômes d'un data management défaillant

Comment savoir si votre organisation souffre d'un data management défaillant ? Certains symptômes ne trompent pas :

- Les silos de données : chaque département, chaque application détient sa propre version de la vérité. Qui a raison ? Personne ne le sait vraiment.

- Des données dupliquées et incohérentes.

- Le manque de visibilité sur les données sensibles.

- Un temps excessif pour produire des rapports fiables.

- Les difficultés à répondre aux demandes RGPD sont un signal d'alarme.

Si vous reconnaissez plusieurs de ces symptômes, votre data management nécessite une refonte stratégique.

Les 5 piliers d'un data management performant

Pilier 1 - Architecture et modélisation des données

Une architecture data moderne combine data lake (données brutes), data warehouse (données structurées pour l'analyse) et data marts (vues métiers spécifiques).

Dans l'écosystème Microsoft :

- Azure Data Lake Storage Gen2 : stockage massif (plusieurs pétaoctets) économique pour tous types de données

- Azure Synapse Analytics : data warehouse nouvelle génération pour requêtes analytiques à grande échelle

- Dataverse : plateforme unifiée pour applications low-code avec sécurité et audit natifs

La modélisation structure logiquement vos données (schémas en étoile, slowly changing dimensions). Les métadonnées documentent le sens, la provenance, la responsabilité et les règles métiers de chaque donnée.

Pilier 2 - Qualité des données

La qualité se mesure selon cinq dimensions, à savoir : exactitude, complétude, cohérence, actualité, unicité.

Dans l'écosystème Microsoft :

- Dynamics 365 : règles de validation à la saisie (email valide, code postal cohérent)

- Power Query et Dataflows : transformation et nettoyage accessibles

- Azure Data Factory : pipelines de qualité automatisés à grande échelle

- Power BI : dashboards de monitoring en temps réel

Vos data stewards sont responsables de la qualité dans leurs domaines respectifs. Sans ce partage des responsabilités, la qualité reste une intention sans concrétisation.

Pilier 3 - Gouvernance des données

La gouvernance définit les rôles clés :

- Data owners : responsables métiers qui définissent les règles

- Data stewards : responsables opérationnels de la qualité

- Data users : consomment selon les permissions accordées

Notez que Microsoft Purview offre un data catalog automatisé qui découvre les données, les classifie et rend leur lignage visible à travers tout l'écosystème Microsoft.

Concernant la gestion des référentiels (master data management), elle garantit une version unique pour les données critiques : un référentiel client unifié dans votre CRM, produit, fournisseur validé.

Enfin, le comité de gouvernance se réunit régulièrement pour définir les priorités, arbitrer les conflits et valider les évolutions.

Pilier 4 - Sécurité et conformité

Selon qu’elles sont publiques, internes, confidentielles ou sensibles, les données nécessitent des protections différentes.

Dans l'écosystème Microsoft, avec une stratégie Zero Trust :

- Azure Information Protection : détection et classification automatiques avec protections déclenchées

- Microsoft Entra ID : authentification et autorisation centralisées

- RBAC : attribue des permissions à des rôles plutôt qu'à des individus

- Conditional Access : MFA obligatoire, blocage selon localisation, restriction des appareils

- Purview Compliance : registre des traitements et automatisation des demandes RGPD

- Data Loss Prevention : bloque le partage inapproprié de données sensibles

L'audit trail trace tous les événements critiques pour enquêter sur les incidents et démontrer la conformité.

Pilier 5 - Intégration et interopérabilité

L'intégration transforme des silos en écosystème connecté via intégration temps réel (APIs, webhooks) ou batch (lots réguliers).

Dans l'écosystème Microsoft :

- Azure Data Factory : orchestration de pipelines de données à grande échelle avec 90+ connecteurs natifs

- Power Automate : workflows métiers low-code pour processus applicatifs

- Connecteurs natifs : intégration transparente Dynamics 365/Dataverse, Power BI/Synapse, SharePoint/Office 365

La gestion des erreurs est cruciale : mécanismes de retry, queues de messages, logs détaillés, alertes automatiques.

.jpg)

Méthodologie : construire votre stratégie de data management

Phase 1 - Audit et état des lieux du patrimoine data

L'audit révèle souvent des surprises : des données personnelles là où on ne les attendait pas, des silos insoupçonnés, des volumes bien supérieurs aux estimations.

Pour commencer, inventoriez toutes les sources où résident vos données : applications SaaS, bases de données, fichiers, services Azure et systèmes legacy. Une fois cet inventaire établi, cartographiez les flux pour comprendre comment les données circulent entre systèmes, révélant les goulots d'étranglement et les processus manuels risqués.

En parallèle, évaluez la qualité en mesurant objectivement l'état actuel : taux de complétude, pourcentage de doublons, cohérence entre systèmes. Ces métriques servent de baseline pour mesurer les progrès. Pour la conformité GED, identifiez toutes les données sensibles : données personnelles, informations confidentielles, secrets d'affaires. Microsoft Purview accélère considérablement ce travail grâce à sa découverte automatisée.

Sur cette base, analysez les risques pour déterminer quelles données perturberaient gravement l'activité si elles étaient perdues ou exposeraient à des sanctions si elles fuitaient. Enfin, mesurez votre maturité via le framework DAMA-DMBOK ou le Data Governance Maturity Model Microsoft, identifiant vos forces et faiblesses par domaine.

Phase 2 - Définition de la stratégie et du cadre de gouvernance

Fort des conclusions de l'audit, définissez maintenant votre stratégie. Celle-ci doit impérativement être portée conjointement par l'IT et les métiers, sinon elle restera lettre morte.

Commencez par définir vos objectifs business : améliorer la connaissance client, réduire les coûts, accélérer la prise de décision, se conformer au RGPD, préparer l'IA. Ces objectifs guident toutes vos priorités.

À partir de là, élaborez votre framework de gouvernance en définissant les rôles (data owners, data stewards), les politiques d'accès, les processus de décision et la fréquence du comité.

Sur le plan technique, choisissez votre architecture cible : data lake sur Azure Data Lake Storage, data warehouse dans Synapse Analytics, Dataverse pour les applications low-code, Purview pour la gouvernance. Pour garantir la cohérence, définissez des standards : seuils de qualité, règles de nommage, formats et documentation des métadonnées.

Face à l'ampleur des chantiers, priorisez via une matrice valeur/effort. Identifiez les quick wins (forte valeur, faible effort) à lancer immédiatement et les projets structurants (forte valeur, fort effort) à planifier soigneusement.

Pour orchestrer l'ensemble, planifiez une roadmap pluriannuelle sur 2-3 ans avec des jalons trimestriels mesurables. Cette planification réaliste évite l'épuisement des équipes et démontre les résultats progressivement.

Phase 3 - Implémentation des fondations techniques

Avec une stratégie claire, vous entrez dans l'implémentation. Construisez des fondations solides et évolutives pour éviter les refontes coûteuses.

Commencez par déployer votre architecture Azure : provisionnez Azure Data Lake Storage avec structure de dossiers appropriée (zones raw, processed, curated), créez Azure Synapse Analytics dimensionné, configurez réseau, firewalls et chiffrement selon le Azure Well-Architected Framework et son guide data workloads.

En parallèle, configurez Purview pour établir la gouvernance : enregistrez les sources, programmez des scans automatiques (quotidiens pour les sources critiques, hebdomadaires pour les autres), définissez les règles de classification et formez les data stewards. Une fois l'infrastructure en place, créez les pipelines d'intégration via Azure Data Factory et Dataflows, avec tests de performance et gestion des erreurs.

Sur le plan sécurité, implémentez les protections essentielles : configurez Microsoft Entra ID avec MFA, déployez le RBAC sur toutes ressources, activez le chiffrement, installez Azure Information Protection, configurez le DLP et activez l'audit.

Pour la qualité, automatisez la surveillance : règles de validation Dynamics 365, dashboards Power BI, jobs de nettoyage automatisés.

Enfin, migrez les données par vagues successives, en commençant par les moins critiques pour valider le processus avant d'attaquer les données sensibles.

Phase 4 - Déploiement de la gouvernance et accompagnement

La technologie en place, vous activez maintenant la dimension humaine. La gouvernance n'est efficace que si elle est adoptée.

Commencez par nommer et former vos data owners et stewards qui piloteront opérationnellement la gouvernance. Formez-les en profondeur sur leurs responsabilités, les outils et les processus.

Parallèlement, déployez le catalogue Purview pour démocratiser l'accès aux métadonnées, accompagné d'une campagne de communication et de sessions hands-on. Pour structurer les accès, formalisez les processus de demande : demande justifiée, évaluation data owner, provisionnement automatique via Entra ID avec expiration et traçabilité complète.

Au-delà des processus, diffusez la culture data via des formations aux bonnes pratiques : qualité, sécurité, RGPD et cloud. Assurez la visibilité par un data governance charter, une newsletter régulière et des champions data dans chaque département.

Enfin, lancez le comité de gouvernance qui se réunit mensuellement pour piloter la stratégie : revue des indicateurs, arbitrages et validation des évolutions.

Phase 5 - Amélioration continue et extension

Le système est opérationnel mais le travail continue. Le data management est un marathon, pas un sprint.

Mettez en place un monitoring via dashboards Power BI consolidant tous les indicateurs critiques : qualité, conformité, usage, incidents. Cette observabilité informatique complète donne aux décideurs la vue d'ensemble stratégique, du DSI aux data stewards.

Pour maintenir la pertinence, organisez des revues trimestrielles qui vérifient l'efficacité des processus et ajustent ce qui doit l'être. Élargissez progressivement le périmètre : après les données clients, attaquez les données produits, finances, RH par vagues successives.

Face aux évolutions, intégrez de nouvelles capacités pour faire évoluer le système : IA générative, temps réel, nouvelles réglementations. Le système reste ainsi vivant et aligné.

Pour finir, maîtrisez vos dépenses Azure via le FinOps data : analysez régulièrement les coûts, migrez les données froides vers des tiers moins chers, ajustez le dimensionnement selon l'usage réel et supprimez les données obsolètes selon les politiques de rétention.

L'écosystème Microsoft offre une palette d'outils remarquablement complète mais encore faut-il savoir les orchestrer avec une vraie stratégie, déployer une gouvernance adoptée, et maintenir l'effort dans la durée.

Askware vous accompagne pour transformer le chaos data en actif stratégique maîtrisé. Notre expertise croise la maîtrise technique pointue de l'écosystème Microsoft et la compréhension profonde des enjeux métiers et réglementaires. Nous ne déployons pas seulement des outils, nous concevons et mettons en œuvre des stratégies qui créent de la valeur.

Envie de structurer votre data management ? Demandez votre audit pour identifier vos vulnérabilités et établir votre roadmap de mise à niveau.